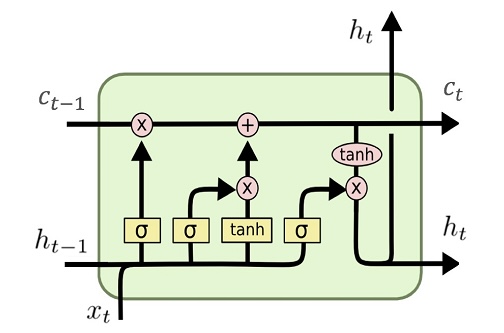

LSTM Cell 위 그림은 LSTM Cell의 구조이다. LSTM의 Cell을 구현한 코드는 아래와 같다. from typing import Optional, Tuple import torch from torch import nn class LSTMCell(nn.Module): def __init__(self, input_size: int, hidden_size: int): super().__init__() self.hidden_lin = nn.Linear(hidden_size, 4 * hidden_size) self.input_lin = nn.Linear(input_size, 4 * hidden_size, bias = False) def forward(self, x: torch.Tensor, h: t..