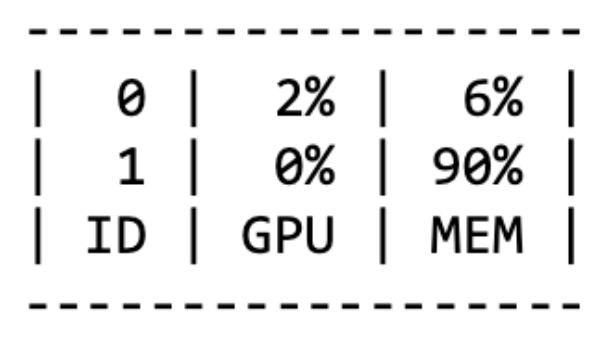

GPUtil GPU의 상태를 보여주는 모듈이다. !pip install GPUtil import GPUtil GPUtil.showUtilization() OOM (Out Of Memory) GPU에서 메모리가 부족할 때 발생한다. batch 사이즈를 줄인 뒤, GPU를 clean 시키고 재실행시켜 본다. del 명령어 python에서는 loop이 끝나도 loop 안에서 선언된 변수가 메모리를 차지하고 있기 때문에, del 명령어를 사용해서 삭제해주는 것이 필요하다. for x in range(10): i = x print(i) # 출력: 9 torch.cuda.empty_cache() 사용되지 않는 GPU 캐시를 정리하여 가용 메모리를 확보한다. del은 객체를 삭제하지만, 해당 객체에 대한 모든 참조가..