sequential data를 처리하기 위한 모델인 RNN(Recurrent Neural Network)에 대해 알아보자.

Sequential Model

- Naive sequence model

- Autoregressive model

- Markov model

- Latent autoregressive model

RNN (Recurrent Neural Network)

The problem of long-term dependencies

RNN 구조에서는 먼 과거에 대한 정보가 잘 고려되지 않는 문제점이 있다.

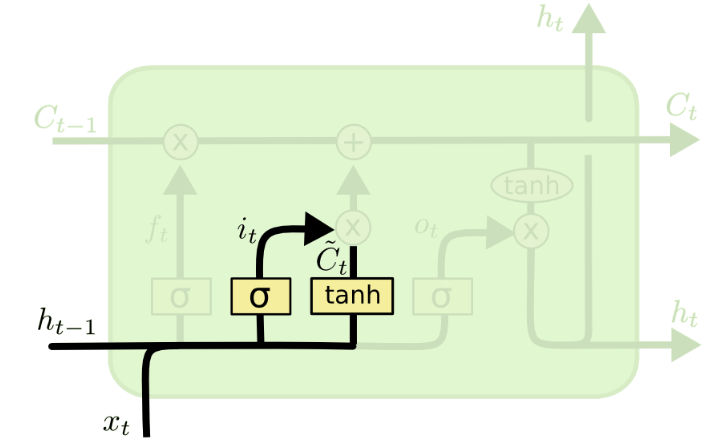

LSTM (Long Short Term Memory)

RNN 구조의 한계인 long-term dependency 문제를 해결하기 위해 등장했다.

previous cell state

cell 밖으로 나가지 않는 정보이다.

이전 time step의 정보들을 요약해서 가지고 있다.

previous hidden state

직전 timestep의 output이다

forget gate

previous cell state에서 어떤 정보를 버릴지 결정한다.

input gate

cell state에서 보존할 정보를 결정한다.

output gate

업데이트된 cell state로 output을 만든다.

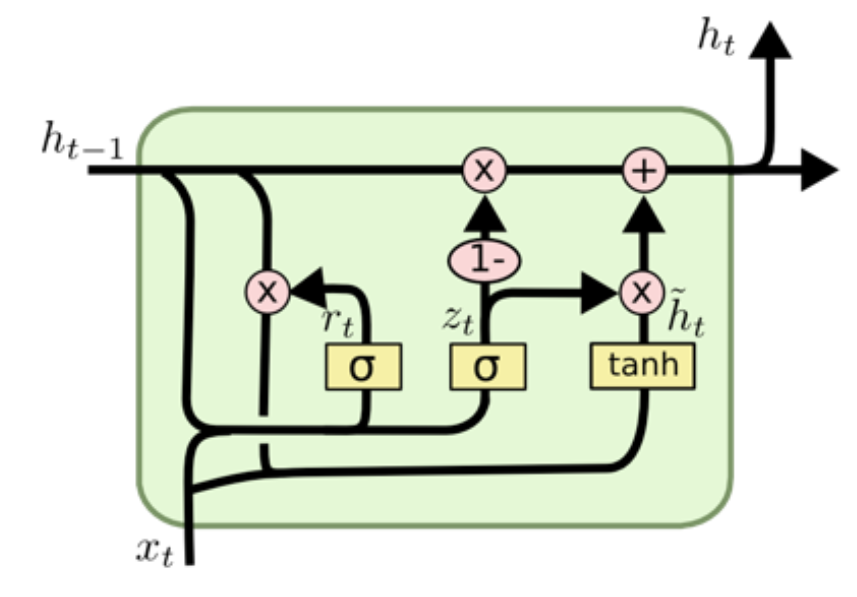

GRU (Gated Recurrent Unit)

2개의 gate(reset gate, update gate)만을 이용해 LSTM에 비해 단순해진 아키텍쳐이다.

cell state 없이, hidden state만 존재한다.

'AI > Deep Learning' 카테고리의 다른 글

| [Deep Learning] LSTM을 직접 구현해보자! (0) | 2023.03.29 |

|---|---|

| [Deep Learning] modern CNN의 특징 (0) | 2023.03.24 |

| [Deep Learning] Regularization (0) | 2023.03.21 |

| [Deep Learning] 최적화 기법 (0) | 2023.03.21 |

| [Deep Learning] 모델 최적화를 위한 중요한 개념들 (0) | 2023.03.21 |