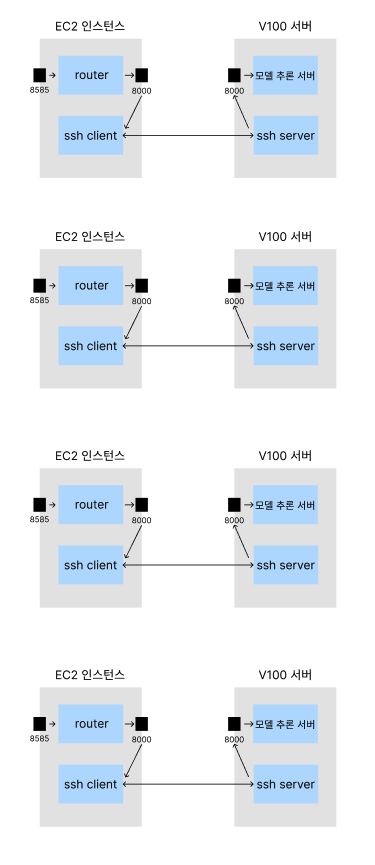

Mojo 🔥: Programming language for all of AI Mojo combines the usability of Python with the performance of C, unlocking unparalleled programmability of AI hardware and extensibility of AI models. www.modular.com 며칠 전 Mojo가 공식 출시되었다. Mojo는 파이썬의 느린 실행 속도를 개선하기 위해 제작한 언어로, 기존에 파이썬으로 작성되어 있던 딥러닝 코드들을 Mojo로 옮겨 실행하면 얼마나 빨라질지 궁금해졌다. 이번 포스팅에서는 Mojo를 설치하고 실행하는 방법에 대해 알아보자. Mojo SDK Mojo SDK는 Mojo의 기본 라이브러리..